M5Stack CoreS3でディープラーニング推論

完成

© CC BY 4+

1103

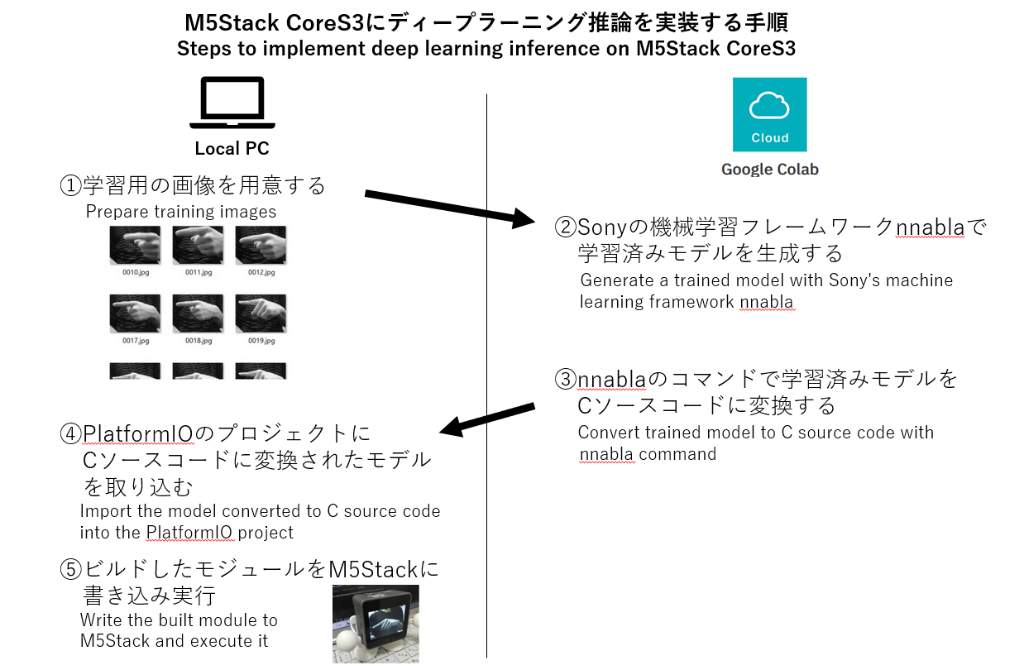

M5Stack CoreS3でディープラーニングの推論を実装できることを確認し、その方法やプログラムをブログとGithubで公開しました。

- 動画

-

- 開発素材

-

- システム構成

-

- ストーリー

-

- メンバー

-

-

- motoh @motoh0917

-

-

- 関連イベント

-

-

M5Stack Japan Creativity Contest 20232023-07-15 開催

M5Stack Japan Creativity Contest 20232023-07-15 開催

-

- 関連リンク

- 同じニオイがする作品

-

-

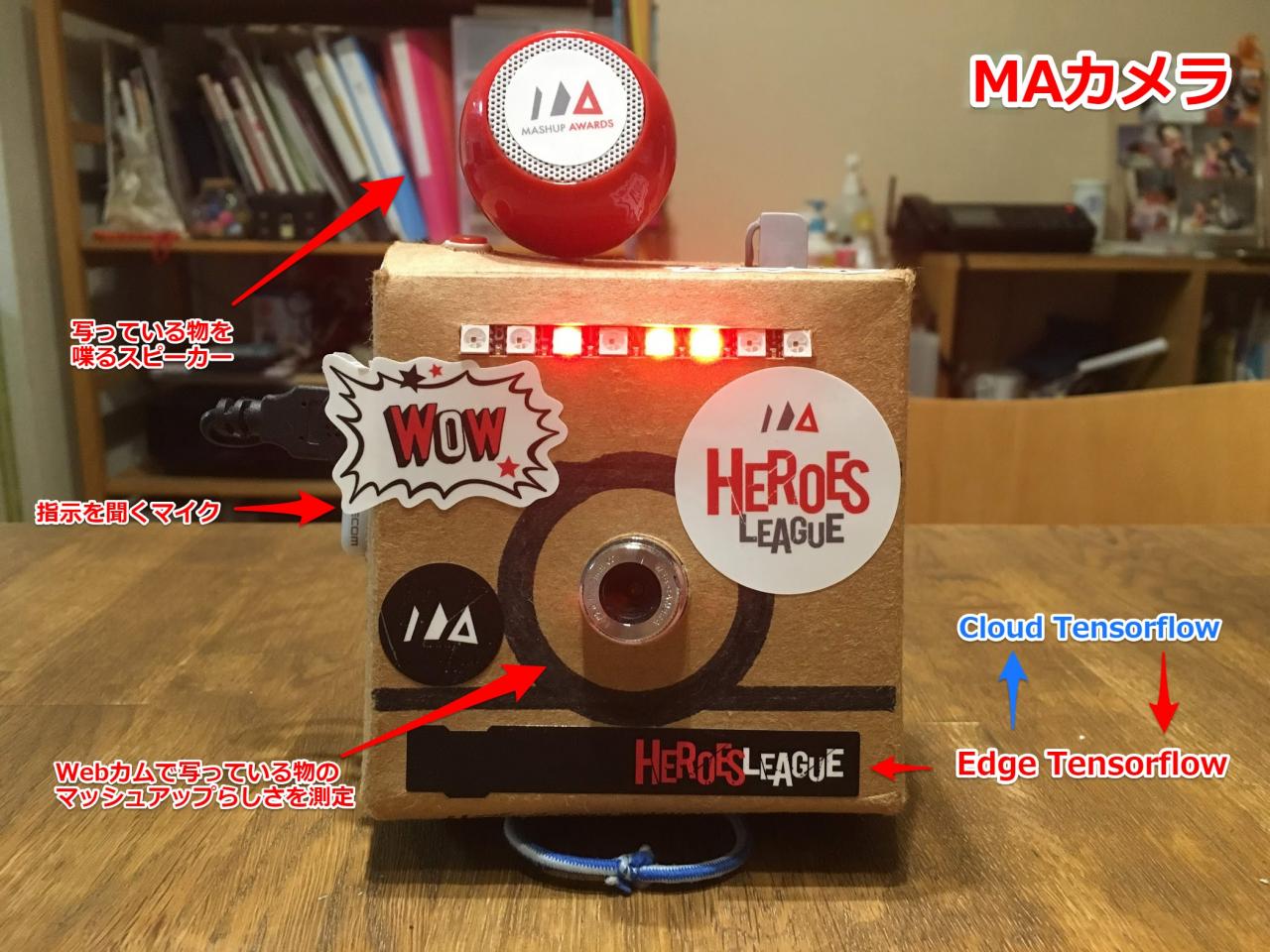

Mashup Camera - MAカメラ

Mashup Camera - MAカメラ

-

トイレの神様

トイレの神様

-

プライベート

プライベート

-

Boundary Blur:球体型ロボットと複合現実を活用したマルチエージェントシステム

Boundary Blur:球体型ロボットと複合現実を活用したマルチエージェントシステム

-