Möbiusschleife: Beyond the Bounds of a VR System

開発中

© CC BY 4+

812

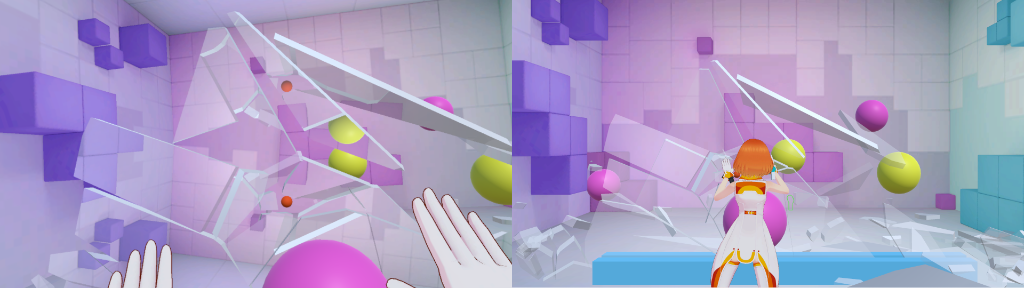

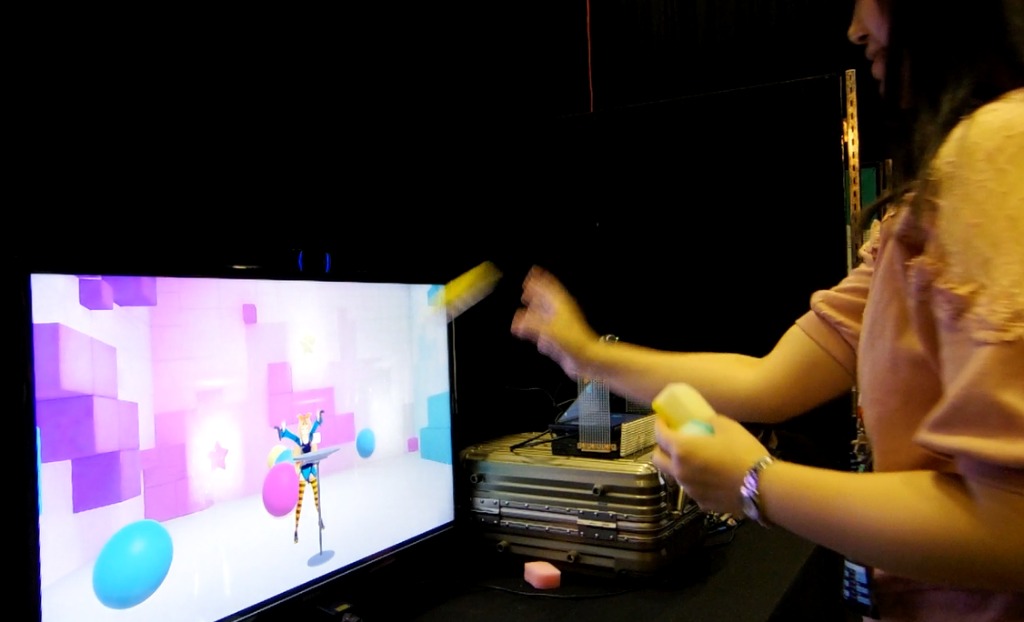

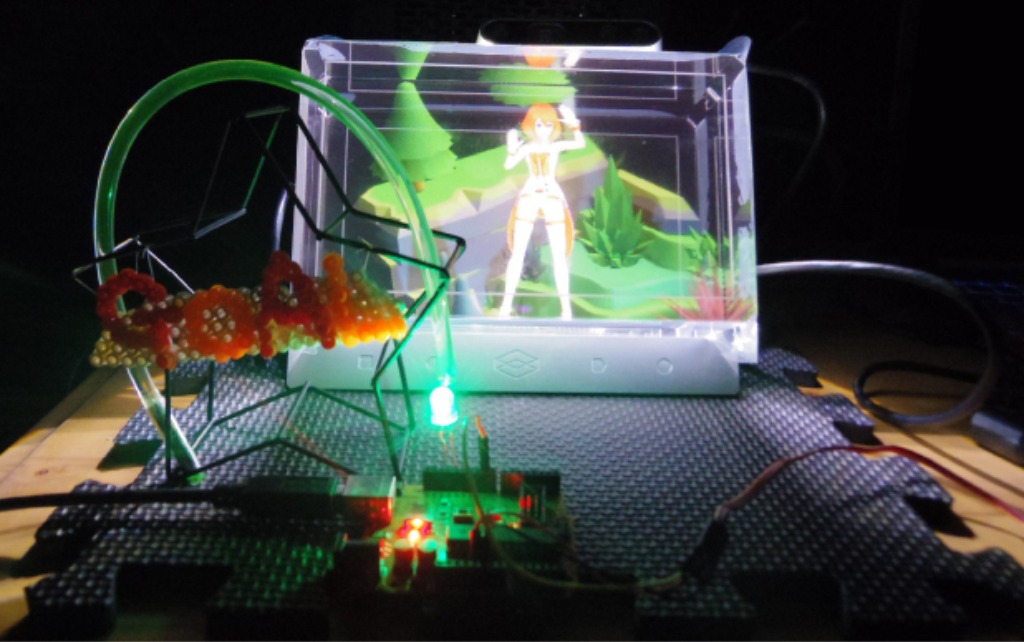

ディスプレイを現実とVRをつなげる「窓」に見立てた、新しいVRインタラクションについての研究です。すぐ横にVRの世界が見えているとしたら、あなたは何をしたいですか?

-

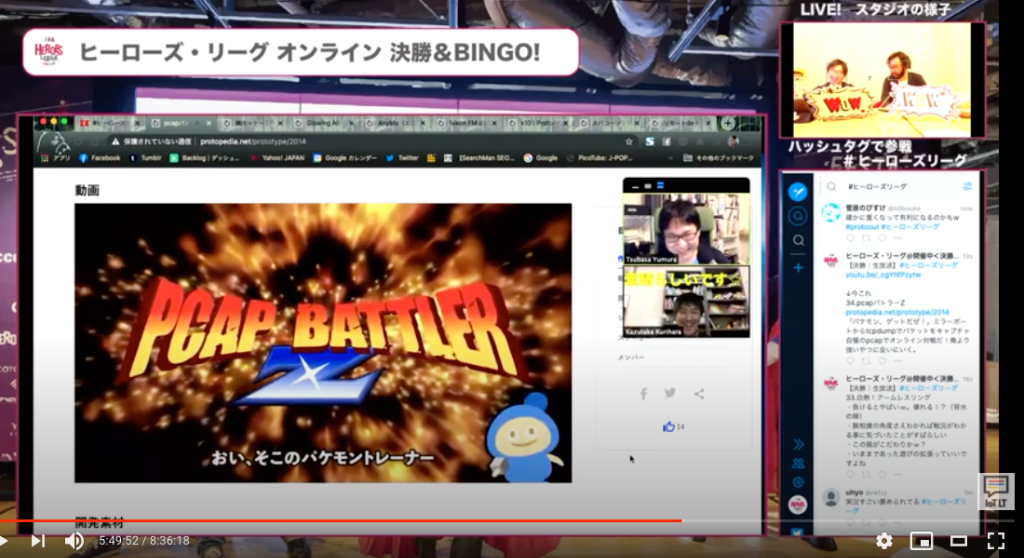

TUD賞 by Tsukuru to Ugoku Design株式会社ヒーローズ・リーグ オンライン2020

TUD賞 by Tsukuru to Ugoku Design株式会社ヒーローズ・リーグ オンライン2020

- 動画

-

- 開発素材

-

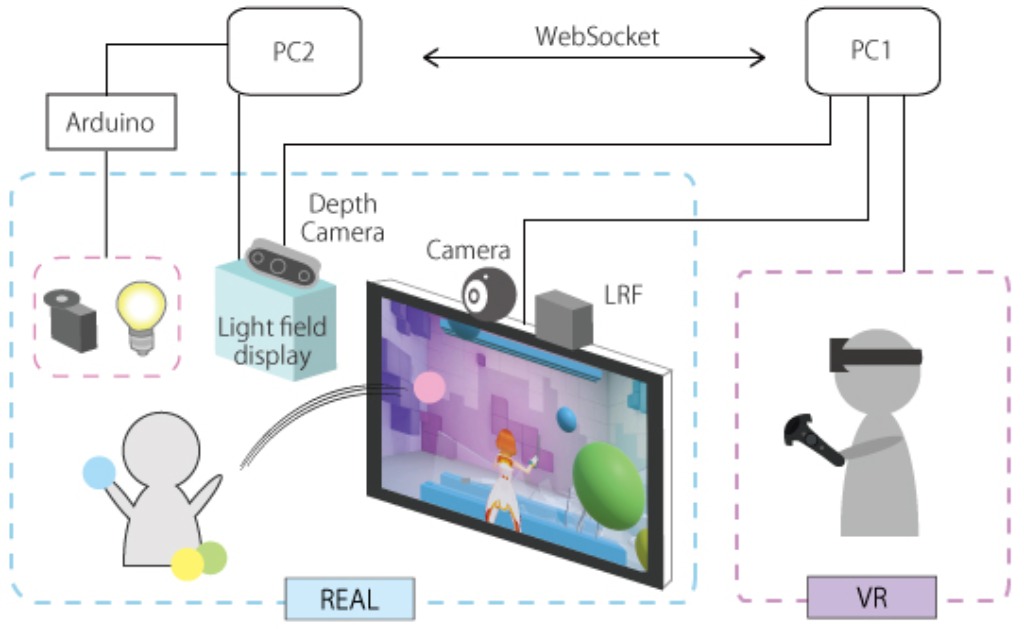

- システム構成

-

- ストーリー

-

- メンバー

-

Revetronique

-

- Revetronique @reve_tronique

-

- テスト

- 動画制作

- 企画

-

- 戸田 光紀 (Revetronique) @koki_t

-

- VR側開発

- エンジニア(Unity,ソフトウェア)

- ハードウェア開発

-

- 関連イベント

-

-

ヒーローズ・リーグ オンライン20202020-09-07 開催

ヒーローズ・リーグ オンライン20202020-09-07 開催

-

HLオンライン2020 決勝2020-12-12 開催

HLオンライン2020 決勝2020-12-12 開催

-

- 関連リンク

- 同じニオイがする作品

-

-

All IoT化システム

All IoT化システム

-

揺らせ!推しへの想い

揺らせ!推しへの想い

-

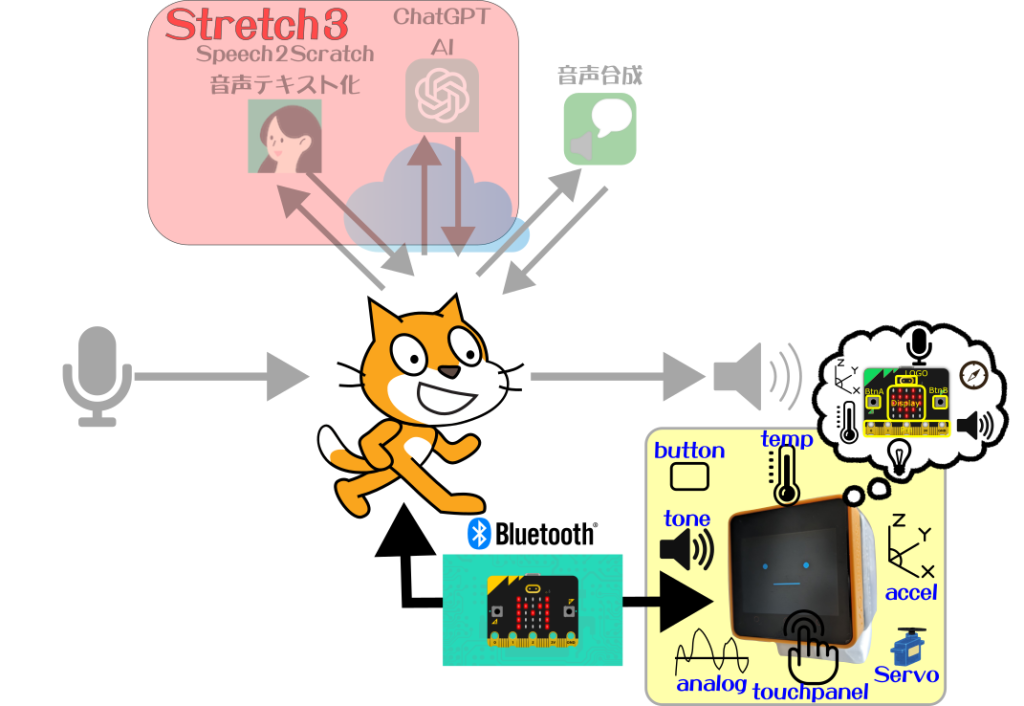

スタックチャン meets Scratch with M5bitLess

スタックチャン meets Scratch with M5bitLess

-

ツッコミの祭点

ツッコミの祭点

-

VRは壁を越えられるのか。という問いかけ的なインタラクション作品。

リアルとの融合の中で、意図せずだと思うけれど神的なものを感じる。

こういうリアルとVRの境界線が溶けるものは面白いなー。

「被ったら独りぼっち」問題を解決できちゃう予感がします、素晴らしいです。

プロトタイピングの定義は「評価のために設計アイデアを客観視し具体化するもの」など、様々なものが存在し、目的も多様だが、私たちとしては、「学習」を目的として重視しています。その中で、本作品はストーリーや技術はもちろん、課題をしっかりと定義し、新しいコンテンツの作成につなげていたところが素晴らしかったです。